BLOG

Come funzionerà davvero la pubblicità nei LLM?

Quello che possiamo scoprire dai risultati della ricerca delle big-tech

Anche io, come molti, negli ultimi mesi mi sono ritrovato a conversazioni con appassioanti del settore Ad-tech dove la domanda ricorre sempre uguale: “Ma come funzionerà la pubblicità dentro i chatbot?”

E anche io, onestamente, ho dato risposte vaghe. “Sarà conversazionale.” “Sarà più personalizzata.” “Sarà nativa.” Tutte frasi che suonano bene ma dicono poco.

Mentre noi discutiamo, tuttavia, qualcuno sta già costruendo. E chiaramente i veri esperimenti — quelli che Google, OpenAI, Anthropic stanno facendo internamente — restano ben nascosti dietro segreti industriali. Non sapremo mai cosa hanno testato davvero finché non lo lanciano.

Ma c’è una finestra aperta per sbirciare nel futuro dell’advertising: i lavori/paper di ricerca scientifica delle big-tech. Laboratori universitari, Google Research (la parte pubblica), conferenze come NeurIPS e KDD. Non sono “la verità” sul futuro dell’advertising, ma ci danno una preview delle traiettorie possibili.

Così ho passato qualche settimana a leggerli. E quello che emerge è affascinante: non stanno limando l’esistente, stanno ripensando dalle fondamenta come allocare attenzione e valore dentro una conversazione.

Qui sotto provo a condividere quello che è emerso — sapendo che è solo una parte del quadro, ma comunque con elementi sufficienti per iniziare a prepararsi.

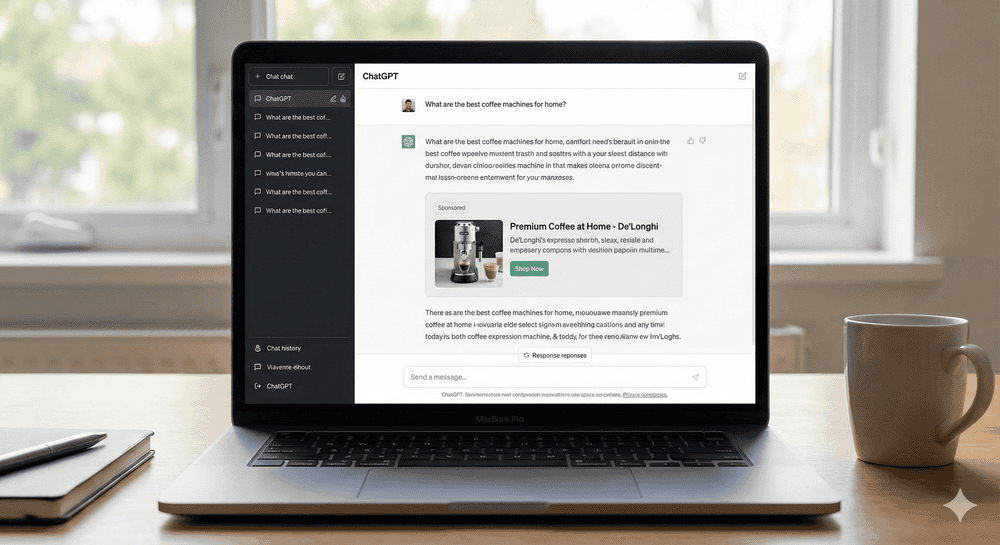

Chiunque si sia posto la stessa domanda è arrivato alla medesima conclusione: se l’ adv classico vive di Banner, slot e posizioni, negli LLM non esisteranno slot. Una risposta è fluida. Può essere breve o lunga. Può includere un prodotto nel secondo paragrafo o nel quinto. Può citare tre brand o zero. La struttura emerge durante la generazione, non prima.

Quindi la domanda vera non è “dove mettiamo l’ad?”, ma: come si alloca valore in qualcosa che si sta ancora formando?

Ed è qui che la ricerca sta convergendo verso qualcosa di radicalmente diverso.

1. L'asta non sceglie più "dove", ma "cosa entra nel processo di pensiero"

Immagina questo: prima che l’LLM scriva la risposta, deve “pensare”. E pensare, per un LLM, significa recuperare informazioni rilevanti.

Un passo indietro: cosa sono i RAG

RAG sta per Retrieval-Augmented Generation.

È l’architettura che ha risolto uno dei problemi fondamentali dei Large Language Model: l’allucinazione e la conoscenza limitata. Un LLM “puro” genera testo basandosi solo sui parametri del modello — quello che ha “imparato” durante il training. Ma questo significa:

- Non sa nulla di eventi dopo il suo cutoff temporale

- Non ha accesso a documenti privati o database aziendali

- Può “inventare” fatti che suonano plausibili ma sono falsi

I RAG risolvono questo in due step:

- Retrieval (Recupero): Prima di generare, il sistema cerca documenti rilevanti in un database esterno. Può essere:

- Una knowledge base aziendale

- Articoli recenti da internet

- Database di prodotti

- Documentazione tecnica

- Augmented Generation (Generazione Aumentata): L’LLM genera la risposta condizionandosi su quei documenti recuperati. Li usa come “contesto” che guida la generazione. In pratica: invece di inventare, cita delle fonti. Questa architettura è diventata lo standard per chatbot aziendali, assistenti di customer service, sistemi di Q&A su documenti. Ogni volta che chiedi a un chatbot aziendale “Qual è la policy di reso?” e ti risponde citando esattamente la policy corretta, c’è un RAG dietro.

E quindi, cosa c'entra con la pubblicità?

Cosa succederebbe se alcuni di quei “documenti recuperati” fossero contenuti sponsorizzati?

È esattamente quello che propone il paper Ad Auctions for LLMs via Retrieval Augmented Generation (NeurIPS 2024, Hajiaghayi et al., University of Maryland e Google Research).

L’idea: l’asta non decide quale banner mostrare. Decide quale contenuto far entrare nel contesto che guida la generazione della risposta.

In altre parole: invece di comprare uno “slot” nella pagina, compri la possibilità che il tuo contenuto sia tra i documenti recuperati — e quindi influenzi cosa l’LLM scrive.

Perché è importante?

Nel mondo della search, compri un click. Nel mondo RAG, compri l’opportunità di essere considerato. Se il tuo brand non è nel contesto, non esiste. Anche se paghi. Per vincere, non basta fare bid. Devi essere il miglior contenuto recuperabile quando l’utente è in quello stato conversazionale.

Questo ribalta il gioco: la creatività non è più un asset fisso (banner, copy). È un insieme di attributi strutturati (specifiche prodotto, proof points, FAQ) che l’LLM può selezionare e ricomporre.

2. Dalla posizione alla "prominence": comprare quota di attenzione

Se non ci sono slot, cosa compri?

La risposta viene da Auctions with LLM Summaries (KDD 2024, Dubey et al., Google Research): compri prominence. Prominence è la quota di attenzione che il tuo brand ottiene dentro la risposta. Una frazione che somma a massimo 1. Nella loro implementazione (chiamata DWLS), prominence = quota di parole. L’asta ti assegna, diciamo, il 30% del budget di parole. L’LLM poi compone la risposta rispettando questa allocazione.

La conseguenza strana

La creatività non è più tua. È generata dall’LLM dentro i vincoli che hai comprato. Tu fornisci i mattoni (dati, claim, value prop). L’LLM costruisce la frase. E qui emerge un trade-off nuovo: più prominence compri, più l’LLM parla di te. Ma se la prominence non si traduce in attenzione reale dell’utente, stai pagando per rumore. Servono quindi metriche di “fedeltà” (faithfulness): l’LLM deve davvero rispettare la prominence assegnata. Altrimenti il mercato collassa.

Cosa significa in pratica

Nasce un’economia dell’attenzione programmabile. Non compri solo dove compari. Compri:

- Quante parole

- Quale densità informativa

- In quale parte della risposta

- Con quale livello di dettaglio

È un controllo molto più granulare. Ma anche molto più complesso da ottimizzare.

3. L'asta diventa un problema di matching (e questo cambia tutto)

C’è un altro passaggio tecnico che ha conseguenze enormi. Nel paper Position Auctions in AI-Generated Content (arXiv 2025, Balseiro et al., Columbia/Google Research) si analizza questo: in un sistema LLM, il CTR non dipende solo dall’ad. Dipende dalla combinazione posizione-creativo-contesto. Quando togli la “separabilità” (cioè: performance dell’ad ≠ funzione semplice di posizione), l’ottimizzazione non è più un ranking. Diventa un general matching problem.

Cosa cambia per i brand

Lo stesso messaggio — “Spedizione gratis” — funziona diversamente se appare:

- All’inizio della risposta (contesto: confronto generale tra opzioni)

- Nel terzo paragrafo (contesto: approfondimento su logistica e tempi)

- Dopo una domanda di follow-up (contesto: obiezione superata)

Questo significa che serve una libreria di claim modulari, non un unico messaggio. Invece di avere un messaggio fisso (“Spedizione gratis entro 24h su tutti gli ordini”), hai una libreria di micro-messaggi adattabili al contesto:

Per contesto di confronto prezzi:

- “Spedizione gratuita inclusa nel prezzo”

- “Nessun costo nascosto alla cassa”

Per contesto di urgenza:

- “Spedizione express gratuita se ordini oggi”

- “Consegna garantita entro 24h senza sovrapprezzo”

Per contesto di affidabilità:

- “Spedizione tracciata in tempo reale”

- “Garanzia soddisfatti o rimborsati sui resi”

Per contesto di sostenibilità:

- “Spedizione carbon-neutral senza costi aggiuntivi”

- “Packaging riciclabile, consegna consolidata per ridurre emissioni”

Per contesto di superamento obiezioni:

- “Anche su ordini piccoli, nessun minimo richiesto”

- “Include assicurazione e gestione danni senza costi extra”

Ogni claim è:

- Standalone: funziona anche da solo

- Compression-friendly: mantiene il senso anche se l’LLM lo sintetizza

- Contestualmente rilevante: risponde a un’esigenza specifica dell’utente in quel punto del dialogo

E la cosa cruciale: serve anche una capacità analitica nuova per capire quale variante performa meglio in quale punto del dialogo. Non è più A/B testing sulla creatività. È contextual optimization: quale claim, in quale momento conversazionale, con quale intent dell’utente.

Questo richiede:

- Tracciare il contesto in cui ogni claim appare

- Misurare la performance per coppia claim-contesto

- Iterare rapidamente sulla libreria basandosi sui dati

In sostanza: la creatività diventa componibile, non monolitica. E il lavoro del marketer si sposta da “creare il messaggio perfetto” a “costruire un sistema di messaggi che l’LLM può orchestrare”.

4. Il tempo diventa una variabile economica (e si possono sponsorizzare le domande)

Neichatbot esiste una variabile che la search classica non ha: il tempo. E non è solo una questione di user experience. È una decisione economica che cambia la struttura dell’asta.

Il tradeoff fondamentale: velocità vs accuratezza

Pensa a questo scenario: un utente chiede “Cerco scarpe da running”.

La piattaforma può:

Opzione A – Mostrare l’ad subito (turno 1)

- Pro: Monetizza immediatamente, non rischia di perdere l’utente

- Contro: Sa poco dell’intent reale (trail? road? principiante? esperto? budget?)

- Risultato: Asta con molti partecipanti generici, ma match probabilmente impreciso

Opzione B – Aspettare 2-3 turni di conversazione

- L’utente specifica: “Per trail, sotto i 150€, piede largo”

- Pro: Intent molto più chiaro, può fare un’asta targettizzata

- Contro: Alcuni advertiser, nel frattempo, sono stati “esclusi” (chi fa solo road running non partecipa più)

- Risultato: Asta più piccola ma match molto più preciso

Questo è il tempo come tradeoff economico: lanciare l’asta presto massimizza la partecipazione ma riduce la qualità del matching. Aspettare migliora il matching ma riduce il numero di bidder (e potenzialmente il revenue).

Come il formato d'asta influenza il timing

Qui arriva la parte contro-intuitiva del paper Ads in Conversations (arXiv 2025, Banchio et al., Bocconi/Google Research). Gli autori dimostrano che il tipo di asta cambia gli incentivi sul timing — sia per gli advertiser che per la piattaforma.

First-price auction (paghi quello che offri):

- Gli advertiser hanno incentivo a ritardare la loro partecipazione

- Perché? Più aspetti, più sai dell’utente, meglio puoi calibrare la tua offerta

- Se tutti aspettano, la piattaforma è incentivata a posticipare l’asta (per massimizzare partecipazione)

- Equilibrio: Aste ritardate, matching accurato, ma rischio di perdere utenti impazienti

Second-price auction (paghi il secondo prezzo + ε):

- Gli advertiser hanno incentivo ad anticipare

- Perché? Il meccanismo truth-revealing riduce il vantaggio di aspettare

- Se qualcuno anticipa, gli altri sono forzati ad anticipare (o vengono esclusi)

- La piattaforma anticipa per evitare che il mercato si “assottigli” troppo

- Equilibrio: Aste anticipate, più partecipanti, matching meno preciso

La scelta strategica della piattaforma

Qui emerge un punto cruciale: la piattaforma sceglie il formato d’asta anche in funzione della sua strategia di timing.

Se la piattaforma vuole monetizzare presto (massimizzare inventory, ridurre rischio di abbandono):

- Preferisce second-price

- Il meccanismo spinge naturalmente verso aste anticipate

- Più advertiser competono (perché non c’è incentivo ad aspettare)

- Revenue potenzialmente più alto (più competition), anche se matching meno preciso

Se la piattaforma vuole ottimizzare la qualità (massimizzare long-term value, trust, satisfaction):

- Preferisce first-price

- Il meccanismo permette di ritardare senza perdere troppi bidder

- Matching più accurato aumenta conversion rate e user satisfaction

- Revenue per-click potenzialmente più alto (migliore match), anche se aste più piccole

In pratica: non è una scelta assoluta, ma dipende dal tipo di conversazione e dagli obiettivi della piattaforma. Non esiste “un formato migliore”, dipende dal tipo di conversazione:

Per query transazionali ad alta intent (“compra iPhone 15 pro”):

- L’intent è già chiaro al turno 1

- Meglio asta immediata (second-price)

- Massimizza competizione e revenue

Per query esplorative (“cerco un regalo per mio padre”):

- L’intent emerge in 3-5 turni

- Meglio asta ritardata (first-price)

- Privilegia qualità del matching

Ma c'è un'altra idea: sponsorizzare le domande, non solo le risposte

Poi arriva un’idea ancora più “LLM-native” dal paper Sponsored Questions and How to Auction Them (arXiv 2025, Bhawalkar et al., Google Research/Purdue). Invece di sponsorizzare la risposta, sponsorizzi la prossima domanda suggerita.

L’LLM propone follow-up per aiutare l’utente: “Cerchi trail running o road running?”

Quella domanda:

- Aiuta a disambiguare l’intent (valore per l’utente)

- Orienta la conversazione (valore per il brand)

- Ha quindi valore pubblicitario

Gli autori mostrano che un design “modulare” — asta separata per la domanda + asta separata per l’ad dopo — è semplice ma strategicamente inefficiente. Meglio una meccanica end-to-end tipo VCG che ottimizza congiuntamente.

L'implicazione nascosta

Se puoi sponsorizzare le domande, puoi influenzare quali opzioni l’utente vede per continuare. Non è manipolazione. Ma la linea è sottile. E questo crea una nuova inventory: non solo “inserire un brand nella risposta”, ma guidare il percorso decisionale dell’utente. Brand che padroneggiano questo possono:

- Qualificare gli utenti in modo più efficace

- Ridurre friction nel funnel

- Aumentare conversion proprio migliorando l’esperienza

Ma serve pensare al marketing come conversation design, non solo message delivery.

5. Oltre il CTR: metriche che proteggono l'esperienza

Ultimo pezzo, più breve ma importante: come si misura il successo?

Nel mondo search bastava il CTR. Nel mondo LLM serve qualcosa di più sofisticato, perché un ad che “funziona” in termini di click ma danneggia l’esperienza è una vittoria di Pirro.

Il paper GEM-Bench (arXiv 2025, Hu et al., National University of Singapore) introduce un benchmark che va oltre l’engagement e include metriche come trust, naturalness, accuracy e personality. Il risultato chiave: metodi che alzano il CTR spesso abbassano fiducia e accuratezza, mentre approcci più sofisticati (“generate first, inject later”) preservano satisfaction ma costano di più computazionalmente.

Il messaggio è chiaro: l’ad deve essere coerente con l’obiettivo dell’utente, altrimenti genera “jump-out feeling” e danneggia la piattaforma nel lungo periodo. Queste metriche non sono ancora standard, ma le piattaforme dovranno bilanciarle con il revenue — e i brand che le capiscono prima costruiranno un vantaggio strutturale.

Mettiamo insieme i pezzi: ecco il sistema

Se sintetizzo questi filoni, la pubblicità nei prossimi 24-48 mesi sarà:

1. RAG come supply chain

L’asta seleziona asset sponsorizzati “recuperabili” che entrano nel contesto di generazione. Non “dove appare”, ma “cosa influenza la risposta”.

2. Prominence come valuta

I brand competono per quota di attenzione: parole, priorità, dettagli. È un budget di “consideration” dentro la risposta.

3. Formati ibridi

A volte l’ad è inserito. A volte è fuso con la risposta organica. Vedi Sponsored Question Answering (Mordo et al., Technion): l’asta decide come integrare, non solo se includere.

4. Sponsored suggestions

Il follow-up diventa inventory. Sponsorizzi “il prossimo passo” che chiarisce l’intent e porta valore sia all’utente che al brand.

5. Multi-objective optimization

Revenue sì, ma sotto vincoli di trust, naturalezza, accuratezza. L’ottimizzazione è multi-obiettivo.

Cosa serve ai brand oggi per essere pronti

Ecco la parte operativa. Non è teoria. È quello che puoi iniziare a fare domani.

1. Costruire un “LLM-ready product knowledge”

Il sito non basta. Servono dati strutturati e atomici:

- Attributi chiari: prezzo, disponibilità, varianti, policy di reso

- Claim + proof: ogni affermazione con fonte, certificazione, review, studio

- Use-case specifici: “Per chi corre su asfalto” vs “Per chi corre su trail”

- Comparazioni oneste: non marketing, ma differenziazione reale

Perché? Perché nel mondo RAG l’LLM pesca ciò che è più utile e verificabile. La creatività fine a sé stessa perde.

2. Produrre creatività modulare

Se la prominence diventa “budget di parole”, devi avere:

- Headline brevi (5-8 parole)

- Bullet di differenziazione (micro-value prop)

- Micro-paragrafi per intent specifici

- Versioni “compression-friendly”: testi che non perdono meaning quando l’LLM li sintetizza

Questo si allinea esattamente al modello prominence/summary dei paper.

3. Ottimizzare per semantic retrieval, non keyword

In pratica:

- Naming coerente di entità e categorie

- Lessico che matcha il modo in cui la gente parla (non come cerca su Google)

- Contenuti pensati per domande, non per pagine

Esempio concreto: invece di “Scarpe running performance alta velocità”, pensa a “Quali scarpe per correre una maratona sotto le 3 ore?”

4. Preparare una libreria di micro-intent per le sponsored suggestions

Se l’inventory diventa “prompt sponsorizzati”, i brand devono mappare:

- Quali domande qualificano l’utente

- Quali riducono ambiguità

- Quali portano a una scelta migliore (e quindi conversione)

Esempio: invece di “Compra ora”, pensa a “Stai cercando per uso urbano o outdoor?” (disambiguazione utile + business value).

5. Cambiare il sistema di measurement

Nuovi KPI da iniziare a simulare:

- Share-of-Answer: quanto la risposta “parla” di te (in % di parole, dettagli, menzioni)

- Prominence share: quota di attenzione/word-budget rispetto ai competitor

- Downstream intent progression: l’utente avanza nel funnel o abbandona?

- Trust score: anche con LLM-as-judge + audit umano (vedi GEM-Bench)

Engagement da solo non basta. Serve tracciare la qualità dell’interazione.

Un pattern che emerge

Guardando questi paper uno dopo l’altro, si vede un pattern: La pubblicità negli LLM non sarà “ads nei chatbot”. Sarà market design applicato al linguaggio: aste che allocano contesto, attenzione e prossimi passi della conversazione — sotto vincoli di fiducia. E questo, tradotto in concreto, significa:

Chi vince non è chi urla più forte.

È chi è più utile, nel momento giusto, nel formato giusto, con le prove giuste.

Cosa puoi fare a partire da oggi

Se vuoi trasformare questa visione in azione:

1) Audit e preparazione

- Mappa il tuo product knowledge: è strutturato? È verificabile? È “retrievable”?

- Identifica i gap: claim senza proof, descrizioni vaghe, dati mancanti

- Crea una matrice intent × contenuto: quali asset hai per ogni micro-intent?

2) Prototipazione

- Sviluppa 3-5 “content unit” modulari (headline + proof + use-case + FAQ)

- Testa retrieval: gli embeddings recuperano il tuo contenuto quando dovrebbero?

- Simula prominence: cosa succede se il tuo brand ha il 20% vs 50% della risposta?

Non serve aspettare che le piattaforme lancino “LLM ads”. Puoi iniziare a costruire gli asset e le competenze oggi.

Author

Alessandro Nuara